Fusion Drive, efficace…

Nous avons publié la semaine passée le test de l’iMac Fusion Drive 27 pouces. En guise de «plus-produit», Macplus vous propose l’analyse du fonctionnement de son disque dur « intelligent ».

Le principe du disque dur hybride est en effet simple, apparu dès 2007 dans le monde PC : il s’agissait d’adjoindre une sur-couche de mémoire flash à un disque dur classique à plateaux, afin d’une part de sécuriser la transmission des données en cours, principalement en cas de rupture d’alimentation sur un ordinateur portable, et d’autre part de limiter les accès disque et la consommation d’énergie, toujours sur les laptop.

L’innovation apportée par Apple propose un système totalement différent, et repose sur l’intuition originelle de Jobs à propos du Macintosh, particulier son obsession à lui attribuer des traits anthropomorphiques. Promis : les lecteurs qui auront la patience d’aller au bout de ce qui suit auront les munitions pour leur prochain dîner en ville, de quoi claquer virtuellement le beignet de la première « bimbo » qui se risquera à glapir que « de toutes traçons Apple c’est mort, et que de toutes façons ils ont arrêté d’innover, quoi… »

Une conceptualisation vieille de 40 ans

Les micro-ordinateurs tels qu’apparus peu après le milieu des années 70, parmi lesquels l’Apple I fait figure de chef de file, sont organisés très simplement autour d’une unité de calcul (CPU), alimentée en données par une mémoire centrale pour son fonctionnement immédiat, et éventuellement par une mémoire de masse pour ce qui est des données moins immédiatement nécessaires, historiquement sur des supports magnétiques (cassettes, disquettes puis disques durs). Sans trop rentrer dans les cas particuliers, la mémoire centrale se compose d’une mémoire permanente, qui enferme le minimum vital dont l’ordinateur a besoin pour commencer à travailler dès qu’il est allumé (Classiquement la ROM ou Read Only Memory), et d’une mémoire volatile où l’ordinateur stocke de façon provisoire les données dont il a besoin pour effectuer ses calculs, avant de passer à la tâche suivante (classiquement la RAM ou Random Access Memory).

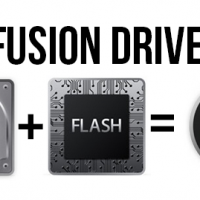

En cela, l’ordinateur reproduit la représentation classique de distinction au sein du modèle de la mémoire humaine et animale, entre Mémoire à Court Terme (MCT, ce qui est immédiatement présent à la conscience, ou qui a été vu pendant la journée, et susceptible d’être oublié si ça n’est pas ” fixé ” de façon durable) et Mémoire à Long Terme (MLT, les souvenirs mémorisés de façon durable, par leur contenu émotionnel ou par la répétition), moins immédiatement accessible mais qui reste néanmoins disponible sur demande, un peu à la manière des volumes d’une bibliothèque.

Cette Mémoire à Long Terme, en principe fixée quasi-définitivement, est organisée selon 2 modes différents, l’un concernant des savoir-faire (mémoire procédurale, puisqu’elle concerne des procédures, que l’on est capable d’effectuer presque sans y penser) et l’autre concernant des contenus susceptibles d’être explicités de façon verbale (mémoire déclarative), par exemple le dernier film que vous avez vu ou l’accident de la circulation auquel vous avez assisté en sortant de la séance.

issue de la psychologie cognitive

Quant à la manière dont le cerveau organise les données et les stocke à partir la Mémoire à Court Terme, elle fait appel au concept de Mémoire De Travail dont le premier modèle avancé en 1968 (Atkinson et Shiffrin) est pratiquement contemporain du lancement du projet du premier microprocesseur par Intel en 1969. Dans ce modèle, les données collectées sont conservées dans un stock très volatile, de capacité très limitée (7 éléments), avant de passer dans la mémoire à court terme ou d’être évacué pour laisser la place à autre chose de plus récent. C’est l’empan mnésique, par exemple à l’œuvre dans la conservation des retenues lors du calcul d’une division à plusieurs chiffres, et qui correspond classiquement sur l’ordinateur à la capacité d’annuler ou de rétablir les dernières actions effectuées grâce au menu Édition. En 1974, Baddeley propose un autre modèle de Mémoire de Travail, plus dynamique, et qui distingue 3 instances : un administrateur central, qui gère simultanément l’attention et le stockage à travers 2 modules :

– l’un est chargé des données verbales et fonctionne par répétition ;

– l’autre dénommé Calepin est chargé des données visuelles et spatiales.

Est-ce vraiment un hasard ? Ce modèle sera formalisé en 1974-75 par l’équipe du Parc de Xerox qui travaille à Palo Alto sur l’interface utilisateur graphique (GUI) à partir des intuitions de Douglas Engelbart, également regroupées dans un ouvrage visionnaire publié en 1968. Les utilisateurs des premières versions du système Mac OS se souviennent très certainement du Calepin (Scrapbook) caché dans le menu pomme, qui permettait de garder sous la main textes et images.

Tout cela est bel et bon, mais si vous êtes toujours avec nous, vous vous rendez bien compte que quelque chose ne tient pas debout, du moins en ce qui concerne le fonctionnement de l’ordinateur : si les « savoir-faire », les compétences de l’ordinateur (les applications) sont bien stockés dans la mémoire de masse (disquette puis disque dur), ils nécessitent également d’être appelés en mémoire vive, avec le lancement de l’application, pour pouvoir être utilisés. Les applications nécessitent ainsi d’autant plus de RAM que leurs calculs sont complexes, et que les fichiers à traiter sont volumineux. Lorsque celle-ci est débordée, le processus de calcul est considérablement ralenti par les accès disques qui sont rendus nécessaires par la mise en place d’une mémoire virtuelle, en écrivant sur le disque dur. Or la mémoire biologique, et singulièrement humaine, ne fonctionne pas ainsi : imaginons la productivité d’un professionnel qui serait obligé de consulter sans arrêt des manuels ou les notes prises au cours de sa formation, pour exercer son métier !

Et le Mac là-dedans ?

Avec sa formidable intuition « d’apprendre l’homme à l’ordinateur » plutôt que l’inverse, l’équipe du Macintosh de 1984 avait bien tenté de résoudre la contradiction, en intercalant une ROM de 64k entre les disquettes de 400k et la mémoire de 128k, qui contenait des pans entiers du système d’exploitation. Ceci afin de soulager d’autant la quantité de RAM utilisée par l’OS ou les applications pour leur fonctionnement, mais la place de celle-ci a diminué progressivement au fil des modèles à mesure que la quantité de RAM disponible augmentait.

Pratiquement 30 ans après, les équipes d’Apple viennent encore une fois de s’appuyer sur les avancées hardware du secteur, tout en s’appuyant sur sa créativité logicielle pour faire avancer l’expérience utilisateur… Comment ?